Intel : bientôt des cartes graphiques pour concurrencer AMD et Nvidia ?

Intel vient de dévoiler un tout premier prototype de GPU, laissant penser que le fondeur souhaite désormais tailler des parts de marché à AMD et Nvidia en vendant ses propres cartes graphiques. Le fondeur suggère que ce premier GPU sera avant tout destiné aux stations de travail professionnelles, avec l'IA comme potentielle application. Une volte-face surprenant : Intel et AMD avaient en effet noué un partenariat pour lancer des SoC hybrides avec GPU Vega.

Quand on pense Intel, on ne pense pas forcément immédiatement à du jeu vidéo. Mais sans doute davantage aux publicités des années 2000 mettant en scène le Blue Man Group, le logo Intel Inside, et sans aucun doute plusieurs de vos ordinateurs, indépendamment de leur puissance. Les gamers ont généralement besoin d'une carte graphique dotées d'un GPU récent, en plus du processeur (Intel ou AMD d'ailleurs), pour pouvoir correctement faire tourner les jeux vidéo. Le marché des cartes graphiques est aujourd'hui largement dominé par le duopole formé par Nvidia et AMD.

Intel dévoile un GPU

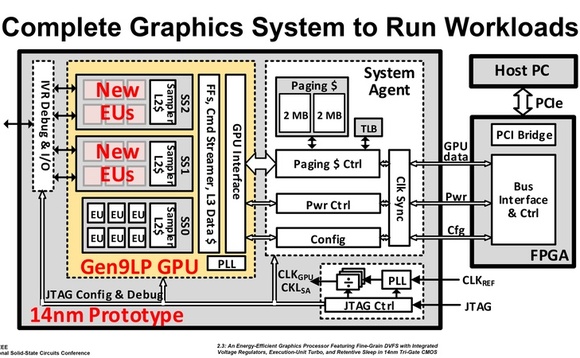

Mais Intel pourrait rapidement changer la donne. Le fondeur a en effet dévoilé à l'occasion du IEE International Solid-State Circuits Conference (San Francisco) un étonnant prototype… de GPU. Celui-ci est gravé en 14 nanomètres et s'articule autour de deux modules : le GPU et le contrôleur système d'un côté et un FPGA (Field programmable gate array) un type de circuit intégré en silicium reprogrammable. En outre il serait doté de 1,542 milliards de transistors. Intel précise que ce prototype a pour finalité de construire “un système graphique complet pour exécuter des tâches de travail“.

Cela ne nous avance pas beaucoup : s'agit-il d'une carte graphique, d'un SoC maison, ou tout autre type d'accélérateur graphique ou système de calcul parallèle ? Selon nos confrères de The Inquirer Intel n'a pas vraiment l'intention de lancer une carte graphique à destination des gamers : le fondeur arrive de toute façon un peu tard dans un marché qui ne l'a pas attendu. Mais davantage une carte qui trouverait sa place avant tout dans des systèmes dédiés au calcul parallèle. Et sans doute aussi des SoC avec CPU + GPU 100% Intel.

Bien que grossièrement similaires (les deux servent à calculer), les GPU et les CPU ne traitent pas les informations de la même manière. La différence entre les deux réside entre autres dans le nombre de threads : jusqu'à plusieurs milliers pour un GPU, vs quelques dizaines pour les CPU les plus puissants et avec le plus de coeurs. Un CPU est ainsi idéal dans les situations où il faut effectuer le plus rapidement des gros calculs de manière séquentielle.

Le GPU est de son côté plus indiqué lorsque l'on cherche à réaliser des milliers de petits calculs en même temps : rendus 3D, calculs scientifiques, intelligence artificielle, mining de cryptomonnaies… le tout avec une meilleure gestion de l'énergie. Intel semble ainsi laisser le marché du jeu vidéo de côté pour créer sans doute davantage un produit à destination des entreprises. Mais pas seulement : il y a quelques semaines, Intel présentait un SoC hybride doté à la fois d'un processeur i5 ou i7 et d'un GPU AMD Vega M GH/GL en fonction des versions.

La maîtrise des GPU pourrait permettre à Intel d'intégrer CPU et GPU dans une nouvelle génération de processeurs. On est impatient de voir ce que cela pourrait donner, pas vous ? On vous propose un peu de nostalgie avec cette publicité Intel des années 2000 :